Мобильная съемка прошла очень большой путь. Сейчас многие люди используют телефоны, чтобы полноценно снимать видео на YouTube, о чем 10 лет назад мы не могли бы даже подумать.

Камеры современных смартфонов уже выдают отличную картинку, учитывая небольшой размер матрицы и оптики.

С чего все начиналось? Почему количество мегапикселей уже давно не говорит о качестве фотографий? Какую роль в камерах смартфонов играют алгоритмы, и как производители будут улучшать мобильную фотографию дальше?

Первый телефон с камерой

В 1999 году японская компания Kyocera выпускает телефон с фронтальной камерой, именно фронтальной. На его корпусе было даже подставка: можно было расположить телефон на столе и делать сэлфи.

Модель назвали Visual Phone 210. Гаджет получил камеру с разрешением 0.1 Мп. Телефон позволял совершать видеозвонки с частотой кадров 2 к/с.

Матрица там была настолько маленькой, что почти не получала света, да и софт гаджета не мог толком обработать информацию, полученную с такого крошечного сенсора. Оттого вместо нормальной картинки получалась лишь кучка пикселей.

Nokia, Siemens, Sony Ericsson

Спустя пару лет стандартом в камерах телефонов стало разрешение в 0.3 Мп. Это в частности телефоны Sony Ericsson K700, Siemens CX65 и легендарная Motorola Razr V3.

На снимках разрешением 640 на 480 пикселей уже можно было различить человека и даже узнать его по чертам лица. Или сфотографировать какой-то крупный текст.

Гаджеты даже умели записывать видео, но в отвратительном по современным меркам разрешение 176×132 пикселя.

Первый камерафон

Все изменилось в 2005 появился легендарный Sony Ericsson K750i – его можно считать первым камерофоном. Телефон имел камеру на 2 Мп с автофокусом и макросъемкой. Качество снимков для того времени было просто отличным, а разрешение готового изображения выросло до 1632×1224 пикселей.

Телефон-камера Nokia N90

В том же году была представлена еще одна легенда Nokia N90 – раскладушка с поворотным дисплеем и поворотной камерой в шарнире корпуса. Более того, N90 – это первый аппарат Nokia со стеклянной оптикой производства Carl Zeiss. Сейчас эта компания известна по премиальным объективам для камер.

В 2006 году финская компания выпускает N93 с камерой на 3.2 Мп и трехкратным оптическим зумом. Телефон снимал видео в разрешении 640×480, 30 к/с. Для того времени это невероятные цифры.

Для сравнения, первый iPhone появится лишь спустя год, в 2007, но он не будет уметь снимать видео вообще, а только фото.

Стоит отметить, что N93 продавался не очень хорошо, вероятно из-за высокой стоимости. Но наравне с Sony Ericsson K750i финский флагман задавал вектор в плане съемки.

4K видео и 20 Мп

Далее многие производители начали представлять свои камерофоны. Разрешение матриц стремительно увеличивалась до 12 Мп, при этом внешние телефоны стали похожи на “мыльницы” (недорогие беззеркальные камеры).

В 2010 году мир увидел iPhone 4 и Samsung Galaxy S. Оба снимали видео в 720p. А к 2013 году почти все флагманы стали снимать уже в FullHD разрешении. Осенью того же года был представлен первый смартфон, снимающий видео в UltraHD – это Acer Liquid S2.

В этот же период Sony выпустила первый смартфон с разрешением 20.7 Мп – это Xperia Z1, но как мы знаем, японцы не смогли написать хороший софт для камеры, отчего снимки получались далеки от идеала.

Но Sony и по сей день не научилась использовать свои же модули по максимуму, другие производители, устанавливая камеры Sony в своих девайсах, получают куда более качественные снимки, чем сама японская компания. Все из-за алгоритмов, о которых мы еще поговорим.

Мегапиксели – это не важно

При этом гонка мегапикселей не могла идти вечно, ведь прироста качества снимков это по сути никогда и не давало. Просто камеры постепенно приближались по разрешению к “зеркалкам”, а само качество снимков упиралось в физический размер матрицы.

Долгое время производителей увеличивали число элементов на ней, но не сам размер матрицы и одного конкретного пикселя. А как мы знаем, чем больше пиксель на сенсоре, тем больше он получает света, а итоговое изображение становится лучше.

Этот подход применила в 2012 году Nokia, выпустив модель Nokia 808. Камерофон имел сенсор на 41 Мп, но не это главное. Размер самой матрицы вырос до 10,5 на 8 мм – это почти в 3 раза больше размеров сенсоров большинства телефонов того времени.

Кроме того, пиксели могли объединяться, чтобы в итоге получать еще больше света, как сейчас это реализовано в 90% Андроидов. Разрешение снимка снижалась с 41 Мп до 5 Мп, но качество фотографии становилась сильно выше, особенно в неидеальных условиях освещения.

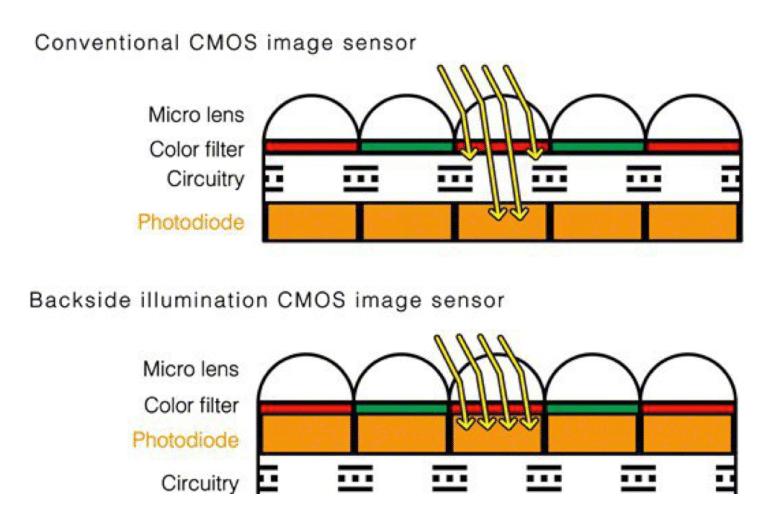

Следом была представлена технология обратной засветки под названием backside illumination.

Теперь все металлические схемы размещались за фотодиодом и больше не блокировали падающий на матрицу свет, что очень важно для качества снимков.

Технологии из профессиональных камер

Вместе с матрицами развивалась и оптика. Производители стали устанавливать в модули все более качественное стекла и все больше открывать диафрагму. Обычно в современных смартфонах сразу несколько линз, от 4 до 7, чем их больше, тем меньше искажений в итоге будет на фотографии. Но при этом слишком много линз может повлиять на светосилу – это вечный компромисс.

В погоне за покупателем и в поиске опыта компании начинают сотрудничать с именитыми производителями оптики Leica, Hasselblad, Carl Zeiss. Их логотипы то и дело появляются на корпусах смартфонов, и чем дальше, тем активнее.

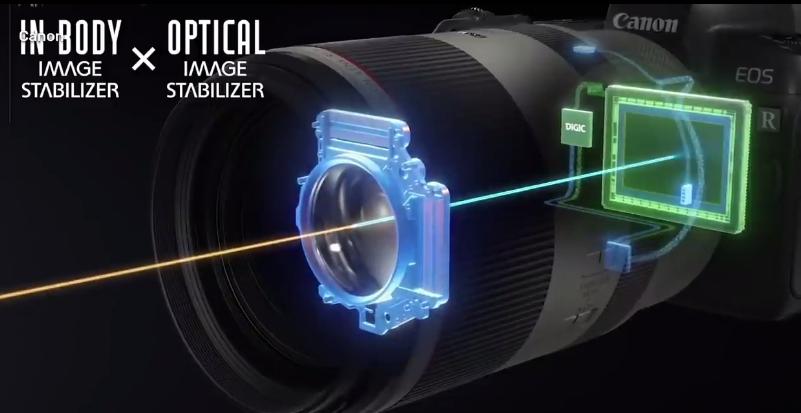

Но что делать с дрожанием рук во время съемки, чем стабилизировать съемку видео? Либо софтом, что чаще происходит в недорогих смартфонах, либо физически, перемещая оптические элементы.

На помощь приходит технология OIS (оптическая стабилизация изображения). Она перекочевала в смартфоны из профессиональной фототехники.

В большинстве девайсов есть встроенный гироскоп и акселерометр, которые реагируют на движение камеры. В соответствии с их показаниями происходит смещение оптики, благодаря чему устраняется эффект дрожания рук. В результате кадры получаются более четкими и менее размытыми, особенно во время съемки на ходу или ночью.

Тут стоит вспомнить и про стабилизацию изображения с сдвигом самой матрицы, как в современных Айфонах, начиная с модели iPhone 12 Pro Max. Но пока что это редкость.

Как же работает электронная стабилизация? Довольно просто. Представьте себе условную матрицу камеры смартфона разрешением 100×100. Если электронная стабилизация отключена, во время съемки используется вся площадь сенсора, то есть все 100×100 пикселей. После активации электронного стаба начинает использоваться не вся площадь матрицы. Основываясь на данных гироскопа и акселерометра, часть изображения перемещается по сенсору камеры, чтобы компенсировать тряску – получается эдакий crop по картинке.

При этом чем сильнее тряска телефона, тем агрессивнее работает электронная стабилизация, и тем сильнее теряет в качестве итоговое фото или видео.

Обе технологии могут дополнять друг друга, именно поэтому многие смартфоны с хорошими камерами оснащаются обеими технологиями для улучшения качества съемки.

Вычислительная фотография

Что имеем в итоге? За пару десятилетий производители увеличили размеры матриц мобильных камер и их разрешение, поработали над технологией засветки сенсоров, стали объединять несколько пикселей на матрице в один, чтобы она получала больше света. Телефоны обзавелись хорошей дорогой оптикой и системой стабилизации.

Но всего этого оказалось недостаточно: физические размеры самих систем камер (матриц и линз) по-прежнему очень малы. Имея просто хорошее железо, нельзя получить хороший кадр при плохом освещении.

И тут на помощь приходят алгоритмы – та самая вычислительная фотография. По большому счету, история вычислительной фотографии началась с появления автоматических фильтров в том же Instagram (запрещен в РФ). Несложный софт накладывал на изображение пресеты, вытягивая провалы в свете и тенях. Кроме того, снимки подвергались небольшой цветокоррекции.

Чуть позже подобным образом дорабатывать изображение стал родной софт смартфонов. Автоматика делала то же, что и кнопка “автоулучшение” в фоторедакторах – вытягивала тени, убирала красные глаза, корректировала цвет лица и в целом тон кожи.

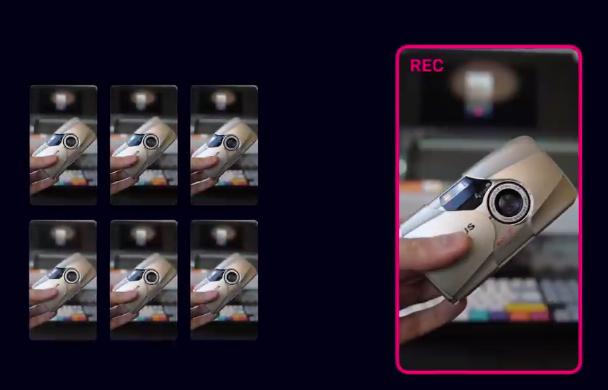

Но все это были лишь зачатки вычислительной фотографии. Настоящие инновации пришли с появлением так называемой “эпсилон фотографии”, или стекинга. Когда несколько снимков, сделанных с разными параметрами экспозиции, склеиваются в 1.

Как только мы запускаем камеру смартфона, она начинает непрерывную съемку незаметно для нас, а когда мы нажимаем кнопку “сделать фото”, камера просто достает несколько последних кадров из буфера и склеивает их. Замечали, как резко начинает греться телефон, когда вы держите открытым приложение камера?

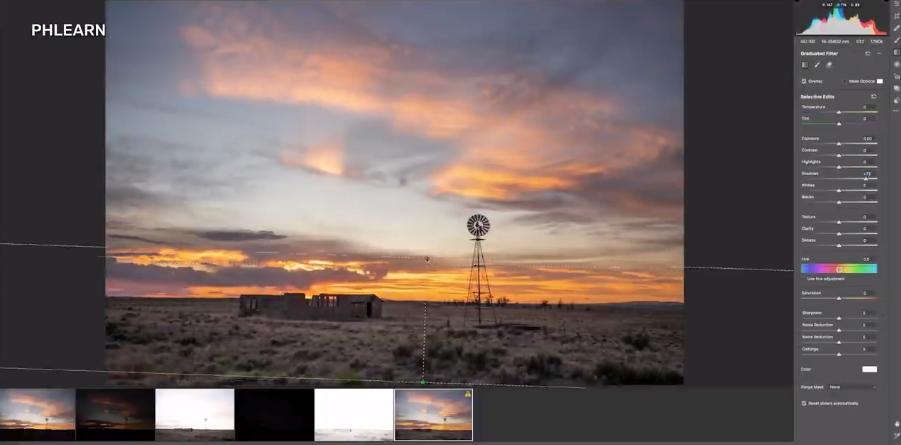

Склеивание нескольких кадров позволяет расширить динамический диапазон, всем известный HDR, с которого собственно и началась повальная революция алгоритмов. Софт соединяет снимки с разной экспозицией, что помогает вытянуть детали кадра в темных или наоборот засвеченных областях.

На большинстве современных смартфонов режим HDR уже включается автоматически, когда алгоритм камеры определяет, что вы снимаете что-то контрастное в солнечный день.

Также стекинг делает фотографию менее шумной. Несколько сделанных кадров подряд позволяют четко определить границы объектов и подавить шум правильно, так как текстура шума на каждом снимке разная.

Еще объединение серии снимков с короткой выдержкой в один программно создает эффект длинной выдержки. Эффект часто используют при съемке звездного неба. На готовом кадре как-будто видно движение небесных тел.

Также склеивание нескольких кадров позволяет программно увеличить глубину резкости. Алгоритмы лучше понимают, где на снимке основной объект, а где фон.

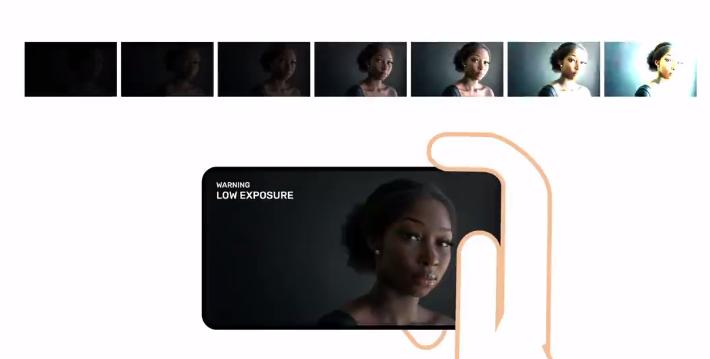

А что по ночной съемке? Считается, что технология впервые появилась в Nexus 5 и называлась HDR+. Работает она так: смартфон определяет, что вы снимаете в темноте, камера накладывает друг на друга несколько кадров, сделанных с короткой выдержкой. Чем темнее сцена или чем больше деталей в тени нужно осветлить, тем больше кадров делает гаджет.

Далее в дело вступают сложные алгоритмы подавления шумов и цветокоррекции. На выходе получаем ночную фотографию почти без шумов с широким динамическим диапазоном и естественной цветопередачей.

Ну а позже компания Google призовет на помощь нейросети. Искусственный интеллект обучили подбирать цвета и выставлять правильный баланс белого – это технология Night Sight. Помимо вытягивания цветов и света, она отслеживает движение в кадре, тем самым софт позволяет избежать появления смазанных объектов при длинной выдержке.

Искусственный интеллект берет четкие части с разных фотографий и склеивает в одну. По схожему принципу делают ночные фотографии и смартфоны Apple. Да, разница в алгоритмах, но суть одна – сделать много кадров и склеить их в один, поработав над светом, тенями и цветом.

Компания Apple сделала очень крутую штуку, привнесла свои алгоритмы в профессиональный формат для съемки и обработки, назвав это все дело Pro Raw.

Минусы алгоритмов

Однако у вычислительной фотографии есть и минусы. Например, на обработку кадра требуется много ресурсов процессора. В итоге смартфон греется, а батарея садится быстрее. А еще на обработку уходит время, как правило, около секунды или нескольких.

А еще недоступен предпросмотр, то есть ты не знаешь, какой фотография получится по итогу. Вероятно со временем процессоры станут настолько мощными, что и обработка ночных фотографий будет происходить практически на лету, но пока имеем, что имеем.

Самый главный недостаток – алгоритмы порой работают слишком агрессивно, делая картинку то акварельный, то слишком контрастной или например увеличивая до неприятных значений микро контраст.

Трипофобия, или боязнь множества камер

Трипофобия – это боязнь или отвращение при виде скоплений небольших отверстий. И говоря о камерах в смартфонах, нельзя не затронуть тренд на увеличение их количества. Иногда кажется, что производители соревнуются в том, кто установит больше камер в свой гаджет.

Самое очевидное преимущество дополнительного модуля в камере – это портретная съемка. Вторая камера помогает смартфону распознать расстояние до основного объекта съемки и в итоге размыть задний фон. Собственно с этой целью и появились первые дополнительные модули.

С телевиком и ультрашириком тоже все понятно. Первый создает перспективу и дает оптический зум, а второй полезен при съемке архитектуры или пейзажей и дает дополнительный простор для креатива. Но есть и более экзотические дополнительные модули в смартфонах.

Например, монохромная камера. Она делает исключительно черно-белые снимки, при этом цветной модуль не может обеспечить такого качества изображения даже после применения черно-белого эффекта, как специальный черно-белый сенсор.

Монохромный модуль делает снимки с большей резкостью и более глубокими тенями, ведь такой датчик не имеет цветного RGB фильтра, из-за чего захватывает больше света. Но в мобильном телефоне увидят разницу единицы, так что технология не стала популярной.

В телефонах сейчас можно найти макро камеру для фотографирования объектов с близкого расстояния, но как правило они снимают хорошо только при хорошем освещении.

Отдельно останавливаться на фронтальных камерах не вижу смысла. Отмечу лишь, что качество снимков на фронталку почти всегда ниже, чем у основных модулей, в первую очередь, из-за размера. Уместить на передней части смартфона крупную качественную матрицу и хорошую оптику сложно.

Что дальше?

Что будет с мобильными камерами в будущем через 3-5 лет? Безусловно, производители продолжат “гонку вооружений”. Ведь сейчас не в последнюю очередь именно камера продает нам определенный телефон.

Но как и дальше улучшать качество фотографии не увеличивая при этом модуль камер? На помощь пришла жидкая линза. Она может менять свою форму под напряжением и моментально фокусироваться, и даже менять фокусное расстояние. Линза занимает мало места в корпусе смартфона, а еще она может заменить несколько обычных стекляшек. Уже есть в смартфонах Xiaomi.

О новых решениях в матрицах смартфонов мы и вовсе почти не слышим. Остается лишь вычислительная фотография, и на наш взгляд, именно обработка снимков станет главным двигателем прогресса на ближайшие годы. Процессоры будут становиться все быстрее, отдельные чипы, отвечающие за постобработку фотографий с помощью нейросетей, постепенно будут становиться дешевле и появляться не только во флагманах.

Ночная фотография станет еще лучше, а на обработку кадров будет уходить все меньше и меньше времени. Цифровой зум с развитием нейросетей будет все меньше уступать в качестве оптическому.

Сенсоры скорее всего продолжат потихоньку увеличиваться, возможно со временем занимая половину задней панели телефона, но смартфоны все равно будут дорисовывать и додумывать львиную часть фотографии.

Камеры современных смартфонов прошли огромный путь. Они фактически полностью убили рынок цифровых мыльниц, оставив лишь единичные варианты для блогеров и пенсионеров. А в некоторых случаях за счет алгоритмов их фотографии не уступают даже зеркальным камерам со стандартными объективами.